CultureMath

Ressources adaptées au programme de mathématiques de terminale S

Le programme des premières S (B.O. 2011) est disponible en version pdf.

Il est découpé en trois grands thèmes (plus deux pour l'enseignement de spécialité), et assorti de deux capacités transversales. Cliquez sur les différents thèmes pour obtenir une liste de ressources CultureMATH correspondantes.

- Analyse

- Géométrie

- Statistique et probabilités

- Arithmétique (enseignement de spécialité)

- Matrices et suites (enseignement de spécialité)

Deux capacités transversales :

Les mots espérance, sort, chance, hasard ont-ils la même signification ? Le concept d’espérance a-t-il précédé historiquement celui de probabilité ? Comment la « géométrie » du hasard initiée par Pascal et Fermat au milieu du XVIIe siècle a-t-elle été propagée dans le monde savant ?

Dans une petite ville du Massachusetts apparaît, au début des années 1980, un nombre important de leucémies infantiles. Faut-il s’inquiéter ? La statistique « inductive » montra que le nombre de cas observés était « significativement » supérieur à la normale et permit de mettre en évidence le syndrome du trinitrotoluène...

La formule dite de Stirling, qui donne une évaluation de n! pour les grandes valeurs de n, est au centre des travaux menés au début du XVIIIe siècle sur les problèmes probabilistes de passage à la limite et d'approximations. Cet article peut se présenter comme un complément au texte sur le théorème de de Moivre-Laplace. La découverte des évaluations de n! par de Moivre et Stirling a donné lieu à des travaux concomitants de ces deux mathématiciens avec des échanges de correspondance, des corrections mutuelles d'erreurs. Ces travaux se situent à un moment que l'on peut qualifier de paradoxal dans l'histoire des mathématiques. En effet les méthodes infinitésimales se développent alors de plus en plus ; elles permettent d'aborder et de résoudre des questions nouvelles. Mais la véracité des résultats obtenus ne peut plus être légitimée par une synthèse démonstrative à la grecque. Il faut donc innover, expérimenter, confronter les résultats obtenus par différentes méthodes ou différents auteurs, avant de pouvoir être sûr de la scientificité d'un énoncé. Nous savons de plus aujourd'hui que certains outils étaient employés sans la rigueur (au sens moderne du terme) nécessaire. Ce sont donc les tours et détours des démarches analytiques du début du XVIIIe siècle que nous voudrions montrer dans ce texte.

Le couple fréquence-probabilité, ainsi que la théorie instituant ce rapport qu'on peut appeler schématiquement "loi des grands nombres", est un leitmotiv de la période classique de l'histoire du calcul des probabilités. Il est au coeur du développement de la théorie et des préoccupations des probabilistes, comme de ses utilisateurs. Les programmes des lycées imposent de prendre une approche fréquentiste pour définir une probabilité. Cela pose le problème du statut de ces énoncés que l'on rassemble sous le nom de "loi des grands nombres". Peu de propositions mathématiques portent ce titre de "loi". Est-ce un théorème, comme il est utilisé habituellement pour le théorème de De Moivre-Laplace ? Est-ce un énoncé extra-mathématique, admis comme prémisse à toute théorie scientifique ?

Les bibliographies consacrées à l’œuvre majeure d’Augustin Cournot sont presque toujours fragmentaires, tant les domaines qu’il a explorés sont divers : mathématiques, économie, philosophie, histoire, sociologie, pédagogie. Or la pensée de Cournot est suffisamment riche et profonde pour ménager un réseau de passages d’un champ à l’autre.

ux États-Unis, dans le climat de guerre froide des années 1950, les mathématiques ont pris une importance stratégique, jusque-là insoupçonnée, dans de nombreux domaines (armements, nucléaire, aéronautique, conquête spatiale ou prévision météorologique)...

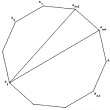

A l’origine du calcul littéral figure notamment la résolution des équations algébriques, de Babylone à Galois. Le problème de la résolution des équations P(x)=0 où P est un polynôme donné possède plusieurs types de réponses, selon ce que l’on en attend : par exemple, développements décimaux d’ordre donné des solutions (heureusement en nombre fini), construction géométrique de segments ayant pour longueurs les valeurs des racines positives de l’équation, algorithmes basés sur des extractions de racines ou emploi de fonctions spéciales (elliptiques par exemple). Leur étude a été un facteur très important de la naissance et du développement des techniques de calcul (littéral ou géométrique). Leur histoire est jalonnée par une liste impressionnante de créateurs : les babyloniens, Euclide, Diophante, Al Khwarizmi, Cardan, Viète, Descartes, Newton, Lagrange, Abel et Galois pour ne citer que ceux-là. Enfin l’informatique est venue modifier, parfois de manière importante, les points de vue que nous avions il y a cinquante ans sur ce thème. Le but de l’intervention est de préciser, à chaque fois de manière simple et assez succincte, que fut l’apport de chacun d’entre eux.

Les ordinateurs sont souvent présentés comme la convergence entre des technologies et les avancées de la logique. Mais ils proviennent également des tentatives pour mécaniser la résolution approchée des équations différentielles, marquées par une hésitation sensible entre approximation par le discret et approximation par le continu. De la machine aux différences de Charles Babbage (1791-1871) au Meccano de Douglas R. Hartree (1897-1958), en passant par l'analyseur harmonique de Lord Kelvin (1824-1907), nous examinerons quelques-unes de ces tentatives et les problématiques qui leur sont attachées.

Voici un texte qui nous a été envoyé par un de nos jeunes lecteurs, Thibault Bourgeron, actuellement en classe de terminale S au lycée Sainte-Marie d'Antony ! Ce travail traite de deux problèmes à résoudre par récurrence.